Hadoop简介

2003-2004年,Google公开了部分GFS和Mapreduce思想的细节,以此为基础Doug Cutting等人用了2年业余时间实现了DFS和Mapreduce机制,一个微缩版:Nutch

Hadoop 于 2005 年秋天作为 Lucene的子项目 Nutch的一部分正式引入Apache基金会。2006 年 3 月份,Map-Reduce 和 Nutch Distributed File System (NDFS) 分别被纳入称为 Hadoop 的项目中

Hadoop

分布式存储系统HDFS (Hadoop Distributed File System )

分布式存储系统

提供了 高可靠性、高扩展性和高吞吐率的数据存储服务

分布式计算框架MapReduce

分布式计算框架

具有 易于编程、高容错性和高扩展性等优点。

HDFS优点

高容错性

适合批处理

适合大数据处理

GB 、TB 、甚至PB 级数据

百万规模以上的文件数量

10K+ 节点

可构建在廉价机器上

HDFS缺点

低延迟数据访问

小文件存取

占用NameNode 大量内存

寻道时间超过读取时间

并发写入、文件随机修改

准备工作

环境

1 2 3 4 5 6 7 JDK:1.8 Hadoop Release:2.7.4 centos:7.3 node1(master) 主机: 192.168.252.121 node2(slave1) 从机: 192.168.252.122 node3(slave2) 从机: 192.168.252.123

安装 JDK

CentOs7.3 安装 JDK1.8

SSH 免秘钥

CentOs7.3 Hadoop 用户 ssh 免密登录

创建用户

建议创建一个单独的用户Hadoop以从Unix文件系统隔离Hadoop文件系统

1 2 3 4 $ useradd hadoop $ passwd hadoop New password: Retype new password:

授权 root 权限,在root下面加一条hadoop的hadoop ALL=(ALL) ALL

1 2 3 4 5 $ chmod 777 /etc/sudoers $ vi /etc/sudoers root ALL=(ALL) ALL hadoop ALL=(ALL) NOPASSWD:ALL $ pkexec chmod 0440 /etc/sudoers

免秘钥登录

安装

下载解压

在 ndoe1 上操作

1 2 3 4 su hadoop cd /home/hadoop/ wget https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-2.7.4/hadoop-2.7.4.tar.gz tar -zxvf hadoop-2.7.4.tar.gz

环境变量

如果是对所有的用户都生效就修改vi /etc/profile 文件vi ~/.bahsrc 文件

1 2 3 #hadoop export PATH=${HADOOP_HOME}/bin:$PATH export HADOOP_HOME=/home/hadoop/hadoop-2.7.4/

使环境变量生效,运行 source /etc/profile使/etc/profile文件生效

配置Hadoop

进入hadoop 配置文件目录

1 cd /home/hadoop/hadoop-2.7.4/etc/hadoop/

编辑 hadoop-env.sh 文件,找到 JAVA_HOME 改为 JDK 的安装目录

1 export JAVA_HOME=/lib/jvm

修改 core-site.xml

打开 core-site.xml文件并对其进行编辑,如下图所示。

1 2 3 4 5 6 7 8 9 10 <configuration> <property> <name>fs.defaultFS</name> <value>hdfs://node1:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>file:/home/hadoop/hadoop-2.7.4/tmp</value> </property> </configuration>

修改 hdfs-site.xml

打开hdfs-site.xml文件并对其进行编辑,如下图所示。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 <configuration> <property> <name>dfs.namenode.secondary.http-address</name> <value>node1:50090</value> </property> <property> <name>dfs.replication</name> <value>2</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/home/hadoop/hadoop-2.7.4/tmp/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/home/hadoop/hadoop-2.7.4/tmp/dfs/data</value> </property> </configuration>

修改 mapred-site.xml

目录下么没有这个文件,这有一个模板,我们需要先拷贝一份

1 2 cp mapred-site.xml.template mapred-site.xml vi mapred-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>mapreduce.jobhistory.address</name> <value>node1:10020</value> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>node1:19888</value> </property> </configuration>

修改 yarn-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 <configuration> <!-- Site specific YARN configuration properties --> <property> <name>yarn.resourcemanager.hostname</name> <value>node1</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

配置集群

复制节点

将 hadoop-2.7.4 文件夹重打包后复制到其他子节点

1 2 3 4 5 cd /home/hadoop/ tar zcvf hadoop.tar.gz hadoop-2.7.4 scp hadoop.tar.gz hadoop@node2:/home/hadoop/ scp hadoop.tar.gz hadoop@node3:/home/hadoop/

在其他子节点 解压

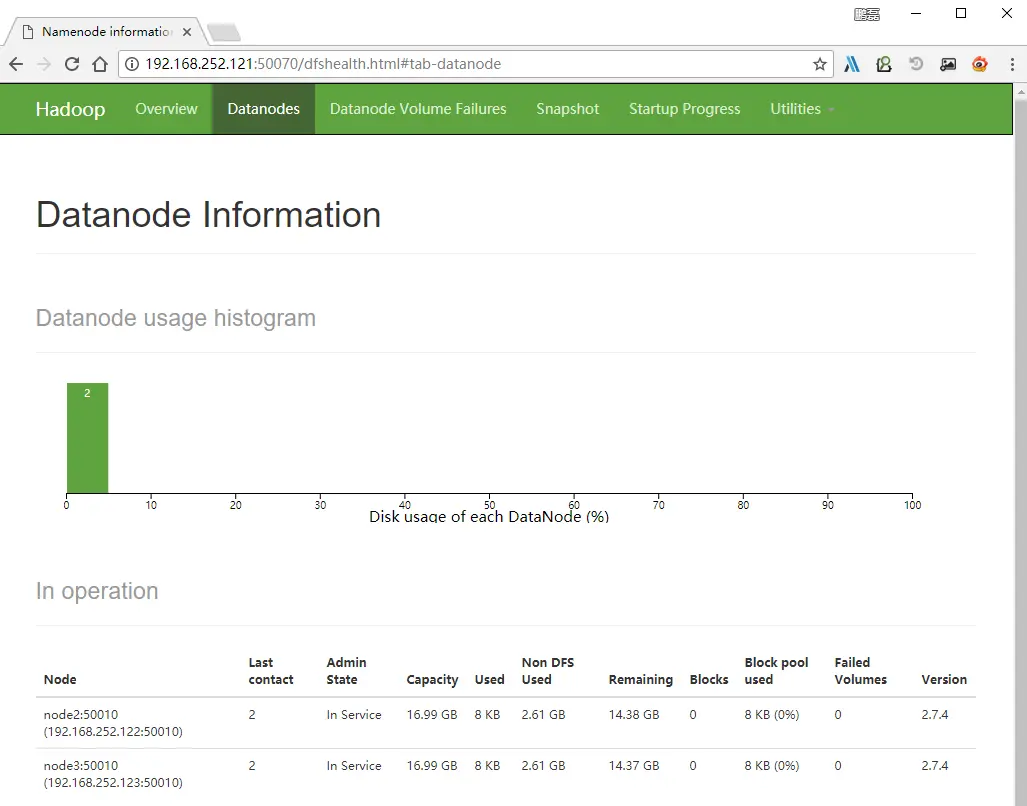

配置slaves文件

修改(Master主机)node1/etc/hadoop/slaves该文件指定哪些服务器节点是datanode节点。删除locahost,添加所有datanode节点的主机名

1 2 3 4 5 cd /home/hadoop/hadoop-2.7.4/etc/hadoop/ [hadoop@node1 hadoop]$ cat slaves node2 node3

集群操作

格式化namenode和datanode并启动,(在master上执行就可以了 不需要在slave上执行)

1 2 3 4 cd /home/hadoop/hadoop-2.7.4/bin ./hadoop namenode -format ./hadoop datanode -format

启动 hadoop

关闭防火墙

1 systemctl stop firewalld.service

1 2 3 4 5 6 cd /home/hadoop/hadoop-2.7.4/sbin ./start-dfs.sh ./start-yarn.sh ./mr-jobhistory-daemon.sh start historyserver

或者

1 2 3 ./start-all.sh ./mr-jobhistory-daemon.sh start historyserver

查看进程服务

查看启动进程,缺少以下任一进程都表示出错

1 2 3 4 5 $ jps 2528 NameNode 2720 SecondaryNameNode 2872 ResourceManager 3151 JobHistoryServer

查看端口占用情况

1 netstat -tnlp | grep java

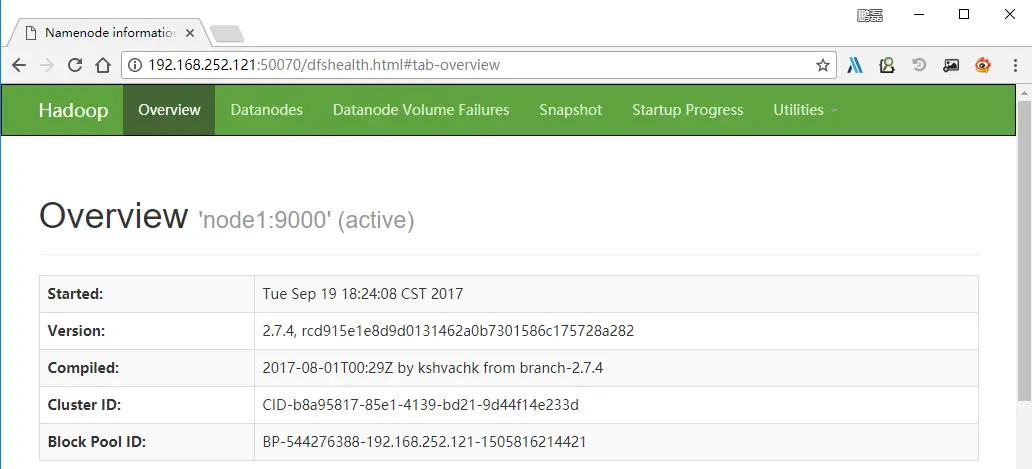

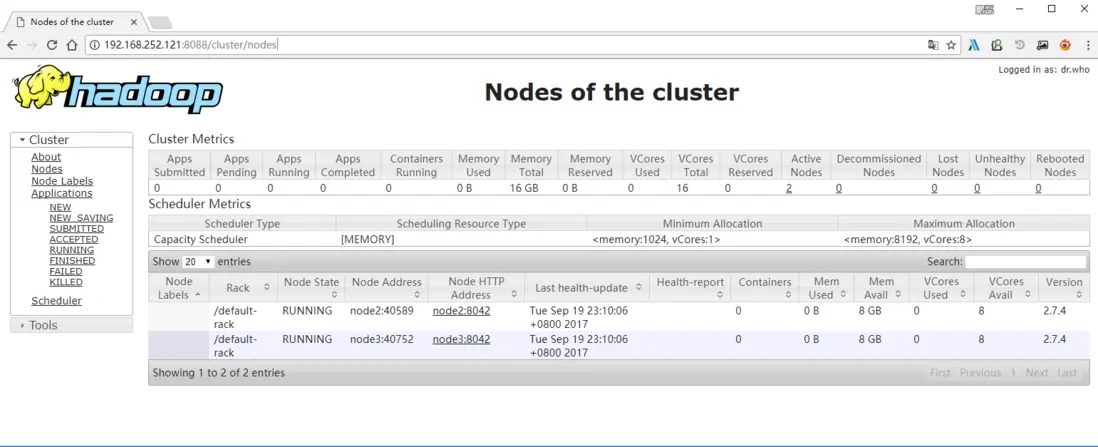

访问node1

1 2 3 http://192.168.252.121:50070 http://192.168.252.121:8088

停止 hadoop

1 cd /home/hadoop/hadoop-2.7.4/sbin

或者 jps 查看进程kill 掉

留言與分享